겉바속촉

[보안] 웹 해킹_개발자도구, 검색 엔진, OWASP 본문

웹 해킹

브라우저의 확장 기능 활용

- 브라우저에 있는 확장 기능 이용하여 사이트 구조 파악이 가능

- 웹 브라우저의 도구 메뉴에 있는 개발자 도구를 활용

- 공격자 입장 : html 소스의 위치 파악, 구조 파악이 더 용이

다음 확장 기능에서 도구 더보기 - 개발자 도구 클릭

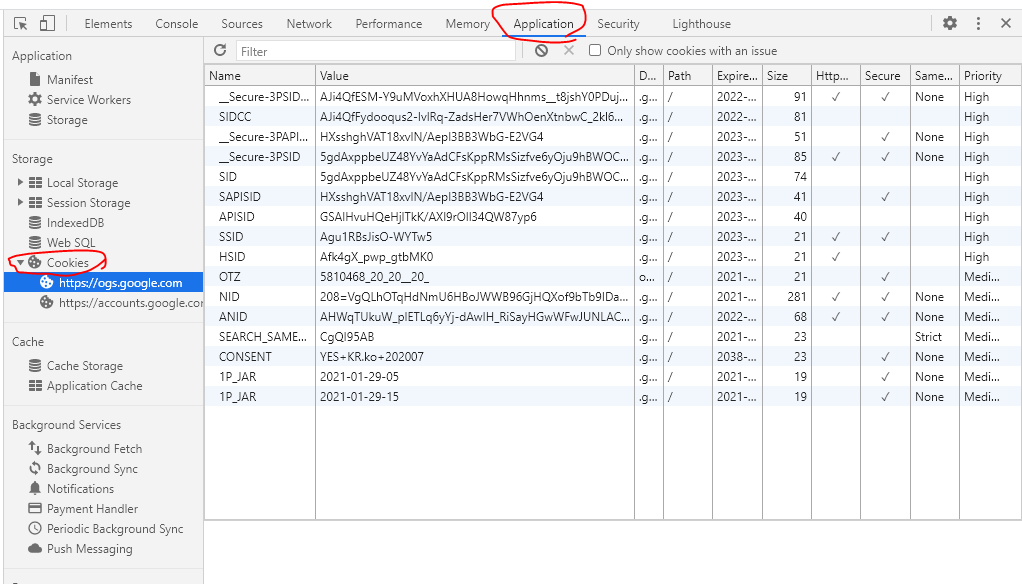

주로 Aplication의 쿠키 데이터들 많이 찾아봅니다.

값을 수정할 수도 있고

세션 정보들이 없다면 쿠키값 내부에 존재할 것입니다.

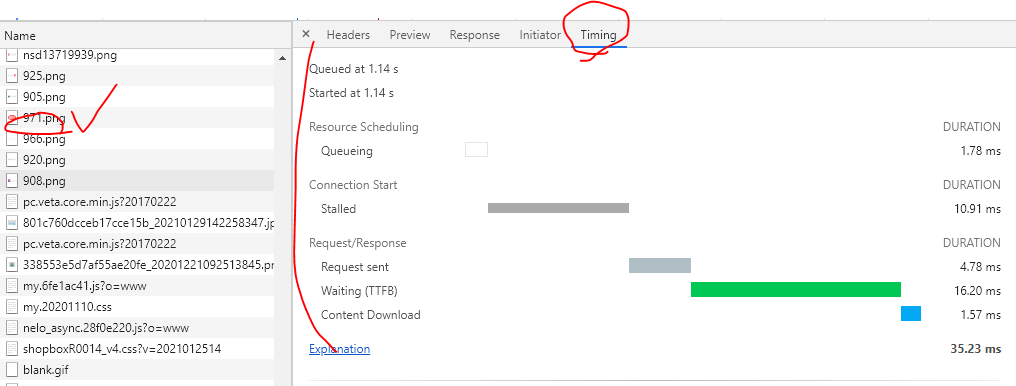

Network 탭에서는 페이지 로드 시간도 측정할 수 있습니다.

다음과 같이 녹화 버튼을 누르고 페이지 방문해주세요

그리고 새로고침 누르면 주르르르르륵 측정이 될 것입니다.

DNS쿼리, SSL 핸드 쉐이크, 다운로드 기타 등등... 이러한 요인들이 로드시간에 영향을 미칠 것입니다:)

다음과 같이 하나 선택해서 로드 되는 시간을 확인해볼 수도 있습니다.

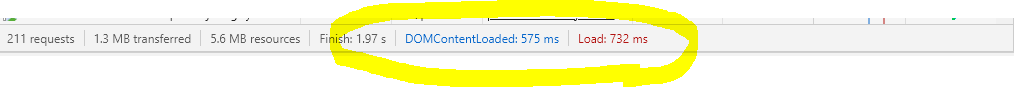

그럼 다음 보이는 파란색 선과 빨간색 선은 무엇을 의미해줄까요?~~

파란색 선 : 네트워크 주고받은 시간

빨간색 선 : DOM 파싱 시간

하단을 보면 전체적인 시간이 출력되어 있습니다.

그리고 Console탭으로 가셔서 자바스크립트 분석도 가능하쥬!!

검색 엔진을 이용한 정보 수집

- 해킹을 할 때 가장 쉽게 많이 수집할 수 있는 방법이 바로 검색 엔진을 이용하는 것

- 구글 사이트 --> 다양한 고급 검색 기능 제공

| 검색 인수 | 의미 |

| site: | 특정 도메인으로 지정한 사이트에서 검색하려는 문자열이 포함된 사이트를 찾음 |

| filetype: | 특정 파일 타입에 한해 검색하려는 문자가 들어있는 사이트를 찾음 |

| link: | 링크에 검색하려는 문자가 들어 있는 사이트를 찾음 |

| cache: | 특정 검색어에 해당하는 캐시된 페이지를 보여줌 |

| intitle: | 페이지의 제목에 검색하려는 문자가 들어 있는 사이트를 찾음 |

| inurl: | 페이지의 URL에 검색하려는 문자가 들어 있는 사이트를 찾음 |

검색 엔진의 검색을 피하는 방법

- 웹 서버의 홈 디렉터리에 robots.txt 파일을 만들어 검색 불가능하도록 만들 수 있습니다.

- robots.txt --> User-agent와 Disallow로 구성

- User-agent: googlebot ==> 구글 검색 엔진이 검색하는 것을 막을 수 있음

- Disallow: dbconn.ini ==> dbconn.ini 파일을 검색하지 못하게 할 수 있음

스캐닝 툴을 이용한 정보 수집

- 웹 스캐닝 (Web Scanning) : 웹 사이트를 조사하는 방법

- 웹 서버 종류, 버전, 디렉터리 정보, 중요 파일 존재 여부, 취약점 등을 검색할 수 있음.

웹 스캐너의 원리

- 동적 : 응답코드를 보고 요청한 페이지 있는지. 서버의 어느 부분이 취약한 지 등을 파악

ATTACKER -----------> TARGET : HTTP Request

TARGET -----------> ATTACKER : Response Code

- 정적 : 개발자들이 편해하는 것이 특징.

시큐어코딩

OWASP Top 10 취약점

- 2004년에 웹 애플리케이션상의 10대 주요 취약점을 발표

- 전 세계적으로 정보 공유

- 2004년부터 2010년까지 발표된 OWASP Top 10을 비교하여 위협이 어떻게 변화하는 지 파악 가능

1. CVE : 알려진 취약점

NVD : 국가 취약점 데이터베이스 --> CVE - 발생년도 - 일련번호 형식으로 정해짐!!

2. CCE : 구성 취약점

3. CWE : 개발 단계에서 발생하는 취약점

<2010년 주요 보안 위험>

- 인젝션 취약점 : 내부 데이터베이스와 연동하여 결과를 보낼 때 주로 발생

- 크로스 사이트 스크립팅(XSS) : 방문자의 쿠키나 세션을 추출할 수 있음

사이트 방문자를 악성코드가 포함된 사이트로 리다이렉션 시킬 수 있음 - 취약한 인증 및 세션 관리 : 보안 설정 잘못했을 때

- 안전하지 않은 직접 객체 참조

- 크로스 사이트 요청 변조(CSRF)

- 보안상 잘못된 구성

- 안전하지 않은 암호 저장 : 사용자 패스워드, 주민번호 등 민감한 개인정보에 강력한 암호화를 비적용한 경우

- URL 접근 제한 실패 : 보호된 페이지에 접근시될 때마다 유사한 접근 통제 확인을 해야 함

- 불충분한 전송 계층 보호 : 비밀번호 등을 입력받으면 해당 페이지를 SSL로 암호화해서 전송해야 함

- 검증되지 않은 리다이렉트와 포워드

'IT 일기 (상반기) > 네트워크 및 시스템 보안' 카테고리의 다른 글

| [네트워크] 웹 서비스 기본3 (0) | 2021.01.29 |

|---|---|

| [네트워크] 웹 서비스 기본 2 (0) | 2021.01.29 |

| [보안] 체크리스트, 모의 해킹 비교 (0) | 2021.01.28 |

| [보안] 웹 해킹 (0) | 2021.01.28 |

| [보안] 웹 애플리케이션 (0) | 2021.01.28 |